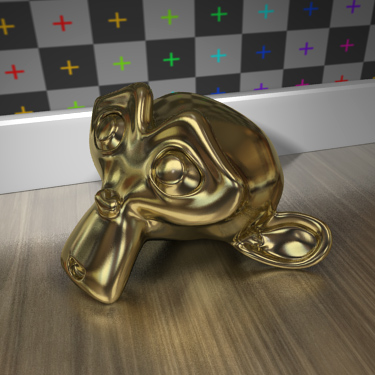

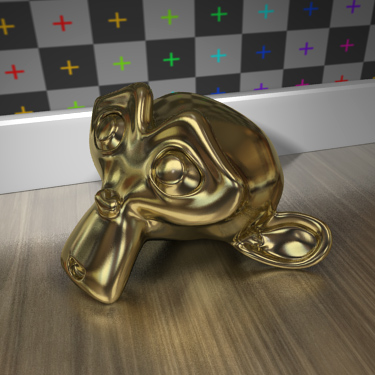

Raytracing difuso para el motor de render interno:

http://projects.Blender.org/tracker/..._id=9&atid=127.

Refracción difusa en Susi y reflexión difusa en el suelo:

Reflexión difusa en Susi y en suelo:

Raytracing difuso para el motor de render interno:

http://projects.Blender.org/tracker/..._id=9&atid=127.

Refracción difusa en Susi y reflexión difusa en el suelo:

Reflexión difusa en Susi y en suelo:

Vaya Blender internal render esta poniéndose calentito calentito.

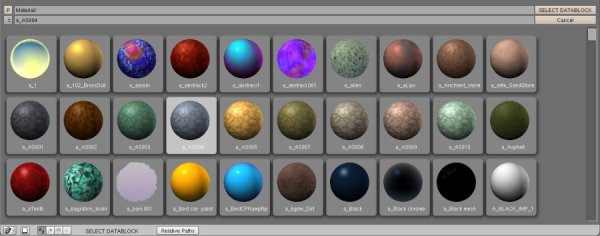

Que buena pinta. Últimamente hay mucha actividad en el SVN (incluidas las ramas de Google summer code). http://wiki.blender.org/index.php/us...ewimagebrowser.

-- IMÁGENES ADJUNTAS --

30 años de Star Wars

Qué buena pinta estos dos parches, que buena pinta. Pero lo que me pregunto, a ver si sabéis algo, hece tiempo que se viene comentando lo del recode del motor de render interno de Blender (incluso creo que fue el verano pasado que se hablaba de basarse en reyes), pero al menos el parche de s es un apaño (pero menudo apaño) para simular ese efecto con el internal renderer actual. ¿desesperados efectos Glossy son más de lo mismo, o se está ya trabajando en el esperado recode? Un saludo.

Cuiño, cuiiiiño!!!!

Qué ganas de tener el filebrowser ese me repatea tener que usar un programa externo para buscar la textura que quiero además parece ser que, soportara también preview de materiales y de.blends.

Elgordo, dudo mucho que haya un recode del internal porque es un mastodonte. Yo creo que los tiros van más por añadir motores externos (mediante el nuevo Api de render) e ir implementando funciones nuevas al internal como es costumbre desde hace años.

Si, desde luego esa parece ser la línea de acción, pero había oído justificar lo del recode porque este sistema de parches hace que como dices el motor sea un mastodonte y esto vaya en detrimento de la velocidad de render en fin, que conste que yo más contento que unas castañuelas con mis reflejos difusos sin subterfugios. Un saludo.

Cuiño, cuiiiiño!!!!

Si se ve ruido, y creo que lo veo, el difuso no es fake. Por cierto, en XSI este tipo de material (de reflexión/frracción difusa rápidas) lo metieron hace poco en la última versión. (el de nativo de Mental Ray resulta muy lento).

...y estaba superbueno.

Y miré su perfil. Y vi que era amigo de Daniela. Puaf.

Dos niñas en el parque

no se elevará, nunca más

Klópes el Shader mi nativo de Mental Ray es rápido, inclusive interpola samples a resoluciones menores, muy rápido y bueno.

Con respecto al Blender internal por ahí alguien quiere sustituir el lento Octre del raytracer por un sistema más eficiente.

Estoy esculpiendo 3.5 millones de quads con 650 Mb, esto está bueno, ahora falta undo a Hd por que eso de apagar el undo no me gusta mucho.

Lo que metieron en el último Mental Ray es justamente eso, que interpole samples para hacer el Glossy más rápido y suave, pero hace mucho que Mental trae reflexiones y refracciones con Glossy (sin la posibilidad de interpolación) en infinidad de Shaders.

Vaya cómo está el tema tú. Unos días sin mirar cosas del Blender y me encuentro todo esto. A ver si todo esto se hacer realizadad en la próxima versión oficial.

Con respecto al de Mental Ray, yo lo decía por la implementación del nodo architectural material, que, por estos lares (mi oficina) estaban muy emocionados porque podía hacer los Trazos cónicos estos. Sabía que ya podía hacerlo antes, pero suponía que era lento porque no lo usaban, así que, utilizan Vray.

Si es que.

...y estaba superbueno.

Y miré su perfil. Y vi que era amigo de Daniela. Puaf.

Dos niñas en el parque

no se elevará, nunca más

Seis días sin aparecer por aquí y ya me han cambiado el programa. Mecachis, que guay. Caronte (y demás), gracias por los truquis, es justo lo que quería saber. Igual valdría la pena abrir un hilo a propósito para tratar el uso de Blender como secuenciador.

Hola, ahora Blender soporta pyconstraints builds para todos. Linux. Linux optimizado para Core 2. Windows.

Si el visualizador tuviera preview de (*.obj), ya seria todo un detalle.

Aqui quiero poner una imagen bonita de mi pagina, pero no puedo...ojete.

Qué divertido.Hola, ahora Blender soporta pyconstraints builds para todos. Linux. Linux optimizado para Core 2. Windows.

Estas líneas emparentan un objeto a otro. No es tontería: es un emparentamiento, normal, pero a este le podemos ajustar la influencia porque ahora es una restricción:

Código:#bpyconstraint. Use_target=true. Def doconstraint(m1, m2, idp): Return m1*m2

...y estaba superbueno.

Y miré su perfil. Y vi que era amigo de Daniela. Puaf.

Dos niñas en el parque

no se elevará, nunca más