Ziva Face Trainer para modificaciones faciales. El especialista en simulación de personajes Ziva Dyamics ha publicado Ziva Face Trainer (ZFT). Un nuevo servicio de manipulación facial basado en la nube y entrenado en aprendizaje automático para juegos y trabajo en tiempo real.

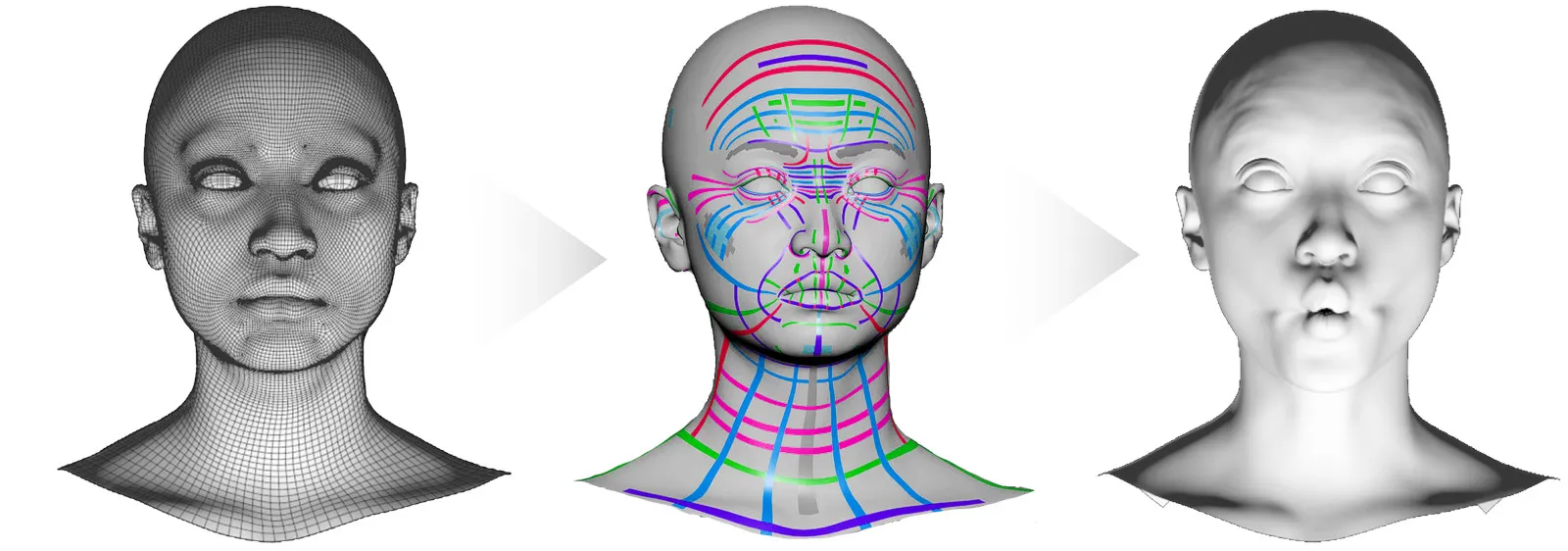

Según Ziva, el proceso convierte una malla facial humana o humanoide estática en una cara en tiempo real de alto rendimiento con compatibilidad total con ARKit. Dicen que lo hace en menos de dos horas.

La firma también ha publicado sus complementos ZivaRT, necesarios para animar el Ziva Face resultante en Autodesk Maya, o para implementarlo en los motores de juego Unity y Unreal Engine.

Ziva Face Trainer para modificaciones faciales

Convierte cualquier malla facial en animación

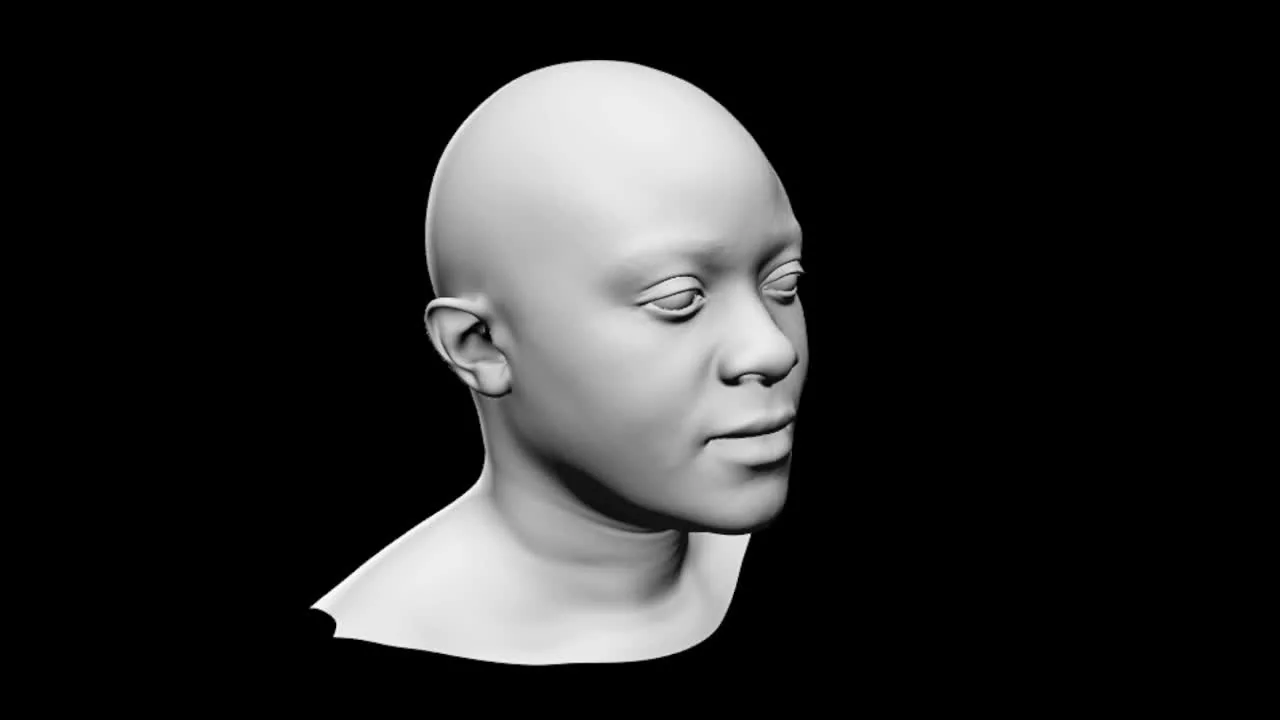

Ziva Face Trainer es capaz de convertir cualquier malla de cabeza humana (oide) en un modelo en tiempo real capaz de realizar más de 70.000 formas faciales distintas. Conocido originalmente como ZRT Face Trainer, Ziva Face Trainer se publicó el año pasado en versión beta cerrada, antes de que Ziva Dynamics fuera adquirida por Unity.

Basado en una biblioteca de 15 TB de datos de escaneo 4D, ZFT convierte una malla de cabeza cargada en formato FBX en un modelo en tiempo real. Capaz de expresar más de 72.000 formas faciales de entrenamiento, junto con las poses faciales novedosas.

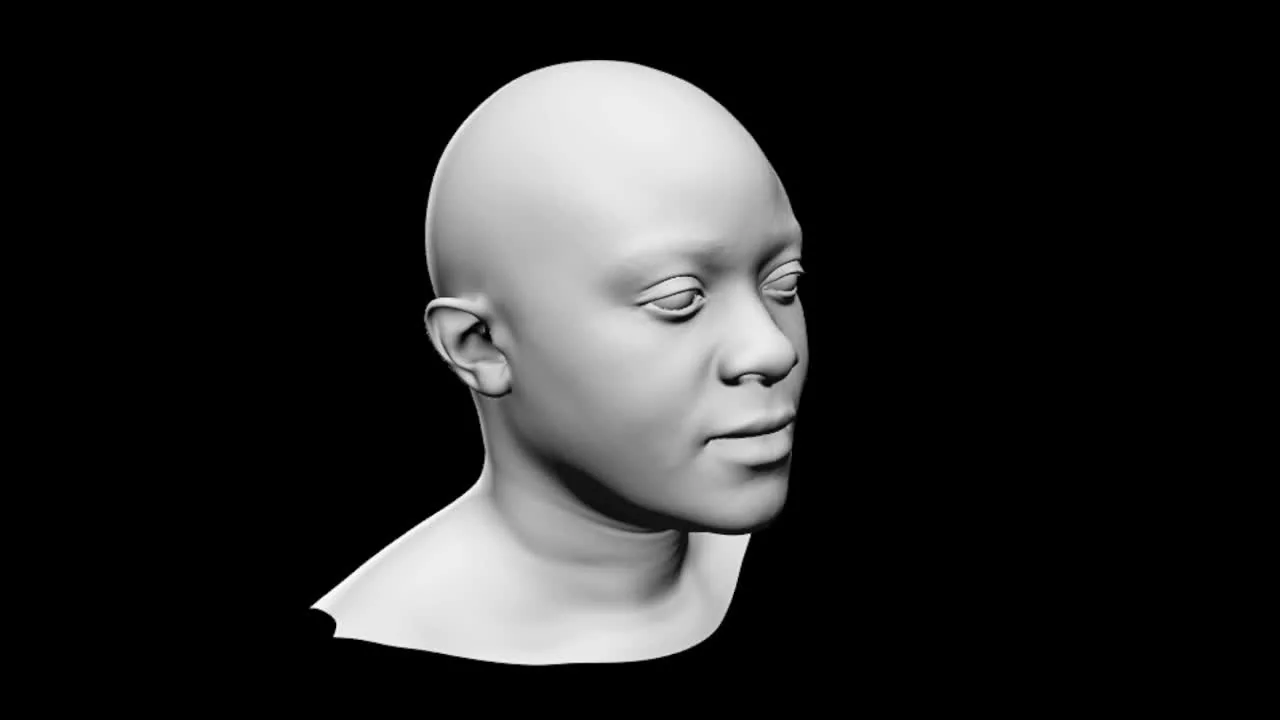

Los Ziva Faces resultantes tienen una huella de memoria de 30 MB en tiempo de ejecución. Se ejecutan a 3 milisegundos por fotograma en un solo hilo de CPU. Lo que los hace adecuados para su uso en juegos y aplicaciones en tiempo real.

Ziva VFX 2.0 para Autodesk Maya

Pasos previos sobre la malla

Antes de que se pueda procesar una malla de cabeza, se debe limpiar y realizar la retopología manualmente para que coincida con un orden de puntos estándar; y se debe subdividir adecuadamente para generar deformaciones convincentes.

Puedes leer una descripción general del proceso, para el cual Ziva Dynamics recomienda Wrap. El software de retopología de R3DS y Autodesk Maya, en esta guía que puedes descargar.

Ziva Face Trainer nos permite medir los resultados en el sitio web del producto. Dispone de animaciones de rango de movimiento estándar para 12 modelos de cabezas humanas y humanoides.

El modelo creado en tiempo real se puede usar en Autodesk Maya, Unity y Unreal Engine; y tiene compatibilidad total con el marco ARKit de Apple. Para ello utiliza las herramientas de captura de movimiento facial. Incluido Live Link Face gratuito de Epic Games.

El uso de Ziva Face en una aplicación host requiere el software ZivaRT Player

Los usuarios podemos cargar una malla de cabeza preparada en Ziva Face Trainer de forma gratuita. Lo que permite obtener una vista previa del resultado antes de comprar una sesión de entrenamiento y descargar el Ziva Face resultante.

Para interactuar con un Ziva Face Trainer dentro de una aplicación host, por ejemplo, para configurar una animación facial en Autodesk Maya. O para implementar el modelo en tiempo real en un motor de juego, se requiere un complemento a parte, ZivaRT Player.

La versión de Unity es gratuita; las versiones de Autodesk Maya y Unreal Engine requieren una suscripción de pago.

Ziva Face Trainer para modificaciones faciales video

Precios y requisitos del sistema Ziva Face Trainer

Es un servicio basado en la nube, por lo que podemos cargar una malla para la cabeza desde cualquier navegador web estándar. ZivaRT Player está disponible para Autodesk Maya en sus versiones 2019 a 2022, Unreal Engine 4 y Unity.

Cada sesión de capacitación cuesta 1800 dólares e incluye suscripciones de un año a ZivaRT Player para Autodesk Maya y UE4. Las suscripciones adicionales para cualquiera de las ediciones cuestan 200 dólares al año. ZivaRT Player para Unity es gratis.

Citar

Citar